在數據分析領域中,特徵選擇(Feature Selection)乃提升模型表現的關鍵步驟之一。特徵選擇指從原始數據集中挑選對預測結果最具影響力的變量,藉此提高模型的準確度及效率。此過程有助減低模型的複雜性,避免過度擬合(overfitting),並增強模型的可解釋性。

特徵選擇的步驟與方法:

(1) 數據理解與處理:

- 數據清洗(Data Cleaning):處理缺失值、異常值和重複數據,確保數據質素。

- 數據標準化(Data Standardization):將數據轉換至同一尺度,例如標準化(standardization)或正規化(normalization)。

(2) 特徵重要性評估:

- 單變量選擇(Univariate Selection):根據統計檢驗選擇特徵,如卡方檢驗(Chi-square test)。

- 遞歸特徵消除(Recursive Feature Elimination, RFE):遞歸地剔除不重要的特徵,直至找到最佳特徵子集。

- 隨機森林重要性(Random Forest Importance):運用隨機森林算法評估特徵的重要性。

- 主成分分析(Principal Component Analysis, PCA):透過線性變換將數據轉換到新的特徵空間,選取主要成分。

(3) 模型訓練與驗證

- 訓練模型:利用選取的特徵訓練機器學習模型。

- 交叉驗證(Cross-validation):通過交叉驗證評估模型表現,避免過度擬合。

(4) 特徵選擇工具與方法:

- Scikit-learn:Python 的機器學習函式庫,提供豐富的特徵選擇方法。

- Featuretools:Python 函式庫,用於自動化特徵工程和特徵選擇。

- Boruta:基於隨機森林的特徵選擇算法,適用於 R 和 Python。

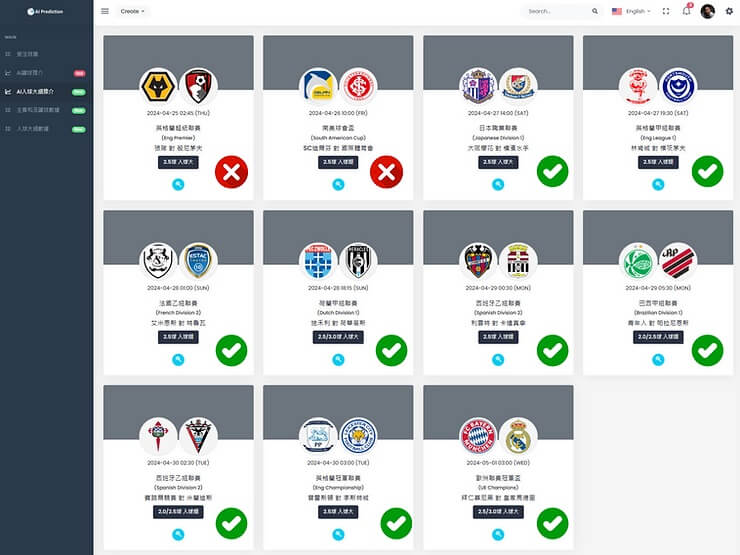

特徵選擇的實際應用: 假設我們正在分析某個聯賽的數據,以下為具體的應用例子:

- 單變量選擇:運用卡方檢驗選取對比賽結果影響最大的球員特徵,如入球數、助攻數等。

- 遞歸特徵消除:遞歸地剔除對預測影響不大的特徵,最終選取最佳特徵組合來預測賽果。

- 隨機森林重要性:使用隨機森林算法評估每個特徵的重要性,選取影響最大的特徵作為模型輸入。

- 主成分分析:透過 PCA 將多維數據轉換為主要成分,降低數據維度,提升模型訓練效率。

通過合理的特徵選擇,我們能夠顯著提升模型的預測表現,並提高數據分析的效率和準確性。